实验环境

| ip | 服务 | 备注(别名) |

|---|---|---|

| 192.168.1.12 | Docker/consul | server1 |

| 192.168.1.13 | Docker | server2 |

实验目的

server1:运行2个容器bbox1和bbox2

server2:运行2个容器bbox3和bbox4

net1(overlay网络):bbox1和bbox4使用通信

net2(overlay网络):bbox2和bbox3使用通信,并手动指定网段为10.10.10.0,且bbox2使用10.10.10.100/24地址,bbox3使用10.10.10.100/24地址

同时bbox1也可与net2网络的容器通信

前面已经有了 Docker 的几种网络方案:none、host、bridge 和 joined 容器,它们解决了单个 Docker主机内容器通信的问题。

本文将介绍docker的跨主机网络的一些基础概念以及简单的结构(overlay)

现在来想一个生产环境,在生产环境中,希望每一台docker主机都只去运行一个服务的集群即可。如

一台docker主机运行web集群

一台docker主机运行mysql集群

一台docke主机运行php集群

可是如果想要这些环境像我们所需要的那样,以LNMP的架构运行,务必每台主机间的容器之间是需要通信的。就用到了本文的跨主机容器通信的方案

实验环境

| ip | 服务 | 备注 |

|---|---|---|

| 192.168.1.11 | DockerA | |

| 192.168.1.12 | DockerB | |

| 192.168.1.13 | NFS&Docker Registry |

实验目的

DockerA主机内创建apache集群三台容器,热数据htdocs目录持久化到本地。(要求页面显示结果为chaiyanjiang.com)

迁移DockerA主机中的apache集群到DockerB中,需要连同htdocs目录内的数据一并迁移(把DockerA主机内的所有数据打包到镜像层中,并上传到Registry中,在DockerB下载该镜像后直接做成集群)

DockerA主机新建三台集群容器,数据来自NFS服务器,内容为“2020ComeOnWH”

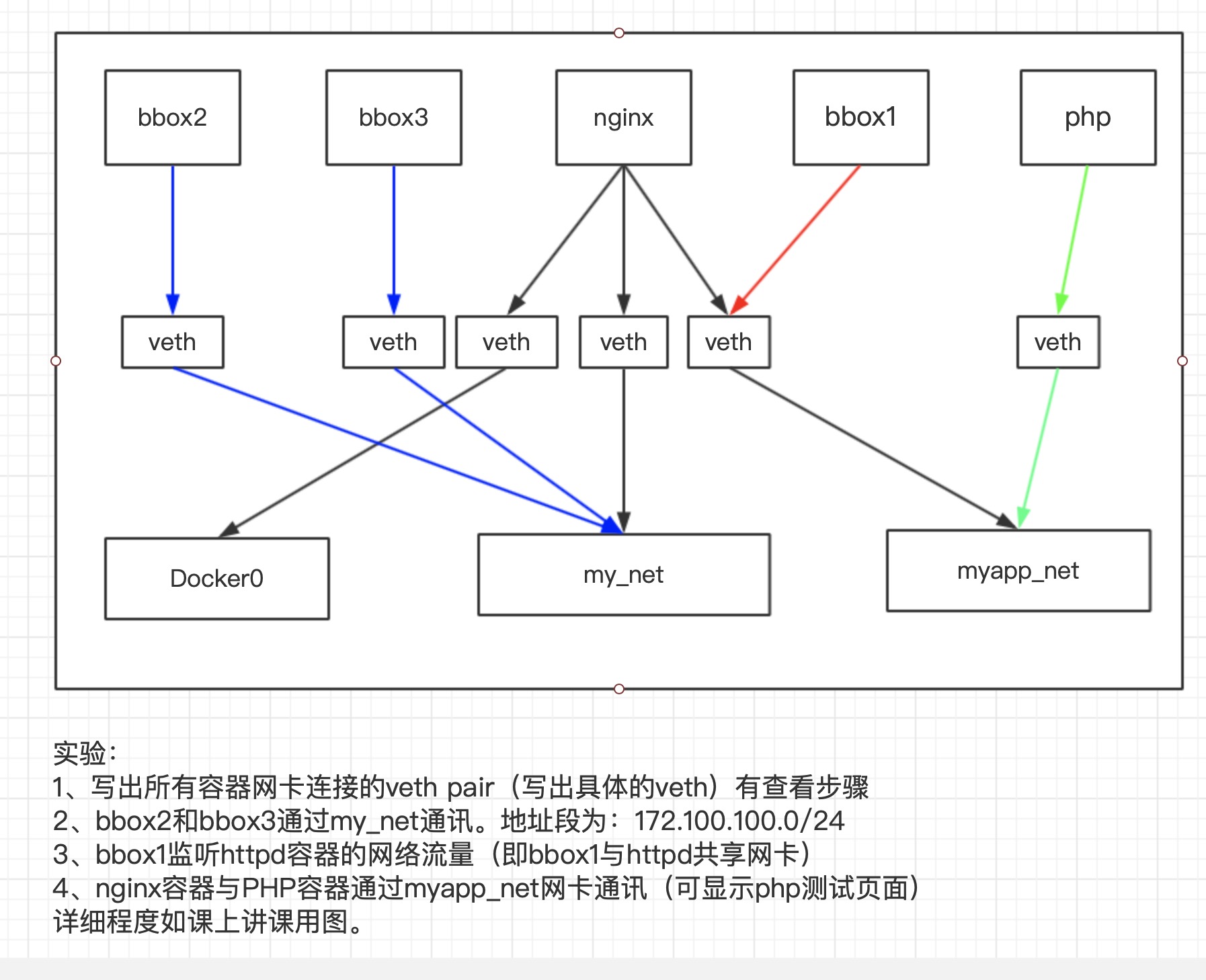

实验如图所示:

实验目的:

将nginx的端口映射到宿主机,通过宿主机来访问到nginx,然后nginx的php设置将会寻找php容器所在,最终显示页面

由Docker公司维护的Registry,用户也可以将自己的镜像保存到DockerHub上中免费的response中,因为在国内访问由很多的限制

登录方法

docker login -u 用户名 密码 https://登录后下载方法

docker pull 用户名/images名:tag